كورس في علوم البيانات

في الأسبوع الماضي حصلت علي شهادة و كورس مجاني متخصص في علوم البيانات و تقنيات الذكاء الاصطناعي Data science and artificial intelligence techniques .مقدم من مبادرة الملكة رانيا إدراك للتعليم الإلكتروني المفتوح بالشراكة مع برنامج developer circles العبقري المقدم من شركة فيسبوك ..أنصح كل من هو مهتم بعلوم الحاسب عدم تفويته لأنه باختصار يضعك على بوابة علم المستقبل علم البيانات و تكنولوجيات الذكاء الاصطناعي Data science and artificial intelligence techniques

أهم ما في الكورس أنه يقدم بلغة عربية سهلة و سلسة تقرب مفاهيم هذا العلم الجديد بلغة بسيطة للمهتمين في مجتماعتنا العربية .

كما أن من أهم ما يميز الكورس أن من يقدمه هي الدكتورة غيدا ابراهيم – عالمة البيانات بفيسبوك – وهي عالمة بيانات عربية من أصل لبناني لها خبرة طويلة في علوم البيانات تشرح جوانب و ملخصات و أحدث ما توصلت له تكنولوجيا الذكاء الاصطناعي ببساطة و سهولة و تقربها بلغة سهلة رغم تعقيد هذا العلم و تشعبه

حقيقة الكورس يحتوي على معلومات هامة و دسمة عن مجال الذكاء الاصطناعي و لا شك أن أي شخص مهتم بمجال تقنيات المعلومات يجب عليه أن يحصل على هذا الكورس خاصة إن كان يخطط للعمل في مجال البرمجيات أو معالجة البيانات أو تكنولوجيات الذكاء الاصطناعي التي باتت جزء أساسي من جميع أنشطة البشر .

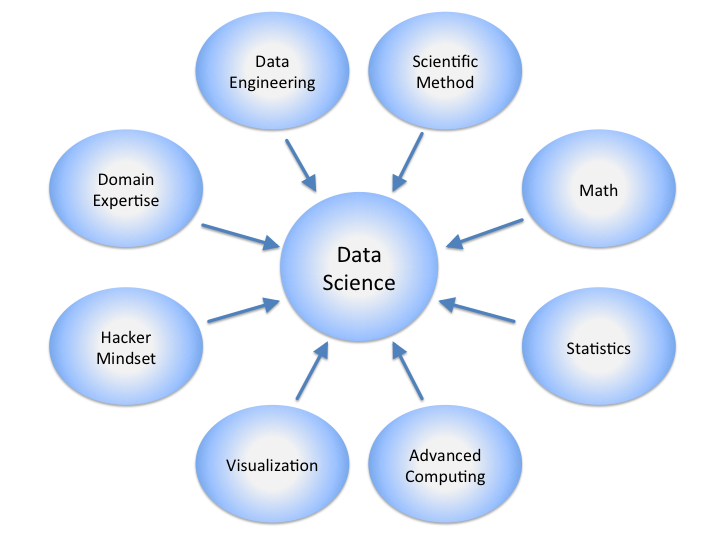

ستخرج من هذا الكورس و قد فهمت بدقة معنى علم البيانات و التعلم الآلي و التعلم الآلي العميق و أشهر تقنيات الذكاء الاصطناعي و أشهر المصطلحات المستخدمة في المجال مع شرح جيد لتطبيقات عملية باستخدام لغة البايثون و مكتباتها العبقرية في تنظيم و تنظيم و تحليل و التنبؤ بالبيانات و شرح مجمل لاهم التقنيات و المكتبات التي تستخدم في بناء تطبيقات الذكاء الاصناعي

ستدرس في الكورس ( كيف تصنع نموذج تعلم آلي Machine learning model – لعمل برنامج قادر على إعطاء نتائج تنبؤية دقيقة لأي في مجال ما ..كالتنبؤ بتحليل صور الأورام و تقسيمها إلى الخبيثة و الحميدة بناء على صفاتها . التنبؤ بحركة أسعار اسهم البورصة – درجات الحرارة المتوقعة – التنبؤ باسعار العقارات بناء على مواصفاتها ..إلخ )

ستتعلم أهم المعادلات الإحصائية و التحليلية لبناء نماذج التعلم الألي و معالجات البيانات الوصفية و التنبؤية مثل ( مكتبات لتحويل البيانات الغير منظمة إلى بيانات منظمة مثل تقنية On Hot coding – مكتبات لتنظيف البيانات و التخلص من البيانات الشاذة و الغير مفيدة – مكتبات و API Data Service للحصول على حجم بيانات ضخم لتجربة إجراء التحليلات و الإحصاءات عليها )

سيتم تعليمك أسس Gradient descent الإحصائية لتنبؤ بأوزان الميزات النسبية في أي معادلة ذكاء اصطناعي

يعني التنبوء مثلا بقيمة المعامل المؤثر بين مساحة الشقة و سعرها بناء على تحليل آلاف من البيانات الفعلية للبيع و الشراء في مدينة معينة

و تعتبر طريقة Gradient descent هي أبسط و أهم طرق تقنيات الذكاء الاصناعي و المعادلات الإحصائية التنبؤية الأساسية للوصول على معامل متوقع منطقي في بناء برمجيات الذكاء الاصطناعي التنبؤية .و سيتم شرح فكرتها ببساطة مع عرض المكتبات الجاهزة في لغة بايثون Python التي تقوم بتطبيق هذه المعادلة و لكن بطريقة أكثر تعقيدا على حجم بيانات ضخمة

ستتعرف أنواع ال Gradient descent مثل batch gradient descent و mini-batch gradient descent و

Stochastic gradient descent و ما هي أفضل طريقة و أمثلها لاستخراج أوزان المعاملات مع استغلال أمثل للموارد الحاسوبية المستخدمة في عملية التحليل.

ستتعلم كذلك تقنيات هامة مستخدمة في علم الذكاء الاصطناعي مثل تقنية logistic regression وهي من أهم أدوات التحليل التنبؤي predictive analysis لعلاج مشكلة التصنيف لمجموعة من البيانات و معرفة الأوزان المثلى لعوامل معينة تؤثر على النتيجة مثل

كيف يتغير احتمال الإصابة بسرطان الرئة (نعم مقابل لا) لكل كيلو إضافي في زيادة وزن الشخص ولكل علبة سجائر يتم تدخينها يوميًا؟

هل يؤثر وزن الجسم وتناول السعرات الحرارية وتناول الدهون والعمر على احتمال الإصابة بنوبة قلبية (نعم مقابل لا)؟

بهذة التقنية العبقرية يمكن الإجابة على هذه الأسئلة بسهولة بناء على بيانات تدريب ضخمة يمكن أن نغذيها لبرنامج يستعمل هذه المعادلة الهامة .

ستفهم تقنية مثل تقنية Decision tree و Random Forest شجرة القرارات أو غابة القرارات وهي أحد تقنيات التعلم الآلي لتنبؤ بنتائج شيء معين يتم دراسته …مثلا في علم الفلك ما هي أقرب الكواكب حولنا قد تحتوي على حياة …يمكن عرض نظام شجرة القرارت على بيانات مستهلكين من حيث ( العمر – المستوى الدراسي – المستوى المادي ) و بناء شجرة قرارات لمعرفة أي الفئات يمكنها شراء منتج معين .إلخ فيمكن التنبؤ بكل ميزة نسبية و بالتالي الوصول لفئات أرجح لشراء المنتج .

ستفهم أن هناك طرق كثيرة لتقنيات الذكاء الاصطناعي كل تقنية تكون الأمثل في الاستخدام في حالة حجم بيانات معينة و طبيعة مشكلة معينة نواجها فالتنبؤ بسعر سهم في البورصة أو بدرجة الحرارة اليوم مشكلة Regression – و ليست مشكلة Classification يعني تحتاج لتنبوء رقمي نحتاج لاستخدام طريقة Regression

ربما المصطلحة صعبة و لكن حين تقوم بالاطلاع على الكورس و فهمها ستجدها بسيطة جدا

ستفهم مشكلة Overfitting – Underfitting و هي طريقة للوصول لعدد الميزات الأمثل للتنبؤ بقيمة متغير معين

مثلا سعر الشقة يؤثر فيه ( المساحة – عدد الغرف – الموقع – ارتفاع الدور – عمر المبني ) إلخ لكن لا يؤثر فيه مثلا عمر المالك فتلك الميزة يجب حذفها و كذلك لا يجب اغفال ميزة مثل ( نوع التشطيب )

ستستخدم مثلا طريقة تسمى regularization للتغلب على مشكلة Overfitting و هي كثرة الميزات غير المؤثرة و ما هي أفضل المكتبات البرمجية المستخدمة في عملية regularization للبيانات

ستعرف أهمية خلط بيانات الاختبار عشوائيا و هي خطوة مهمة جدا للوصول لأفضل طريقة لايتخراج الأوزان النسبية للميزات في بيانات معينة و ما هي المعادلات التي يمكن استخدامها في لغة بايثون لخلط بيانات الاختبار .

في التدريب ستعرف الفرق بين Supervised machine learning – – Unsupervised machine learning

ستعرف طريقة قراءة البيانات لعمل data frame في بايثون بمكتبة شهيرة و هامة جدا pandas

ستتعامل مع مكتبات هامة و سهلة و عبقرية للعرض الوصفي للبيانات مثل دمة في استكشاف البيانات وعرضها Tableau, ggplot2, matplotlib:

ستعرف مكتبات للمعلاجات الحسابية مثل, NumPy,

كما أن هناك مرحلة سيتم عمل تطبيقات عملية عبر منصة جوجل لكتابة أكواد بايثون و تجريب عمل المكتبات البرمجية لتقنيات الذكاء الاصطناعي و تحليل البيانات المذكورة

ستعرف بعد أن تبني نموذج ذكاء اصطناعي كيف تقوم بتقييمه لتعرف هل نموذج تنبؤي و اختباري جيد أم لا بأهم طرق و مؤشرات اختبار نماذج الذكاء الاصطناعي مثل Area under the curve (AUC) و Confusion matrixو accuracy

ستتعرف على طريقة Artificial neural networks الشبكات العصبية الاصطناعية لمعلاجة البيانات و هي الأنسب في معالجة البيانات غير المنظمة كالصور و النصوص و الصوت

و هي من أهم طرق الذكاء الاصطناعي للتعرف على الأصوات و الصور و النصوص و تستخدم في تطبيقات كثيرة مثل

Optical character recognition OCR – تقنيات معالجة صور النصوص

NLP – natural language processing تقنيات معالجة اللغات الطبيعية

القارئ الآلي . برمجيات تصنيف الصور . محول الكتب المصورة إلى نصوص OCR .تحويل الصوت إلى نصوص . تقنيات التعرف على الأصوات و بصمة الصوت و الوجه

Automated reader. Image classification software. Convert picture books to OCR texts. Convert audio to texts. Voice recognition and voice and facial recognition technologies

بعد اتقانك لمفردات هذا الكورس سيمكنك من بدأ بناء مشروعك الاول الذي يعتمد على أحدث تقنيات و مكتبات الذكاء الاصطناعي الحديث

مثل ( البرامج التنبؤية التي تعتمد على تكنولوجيا الذكاء الاصطناعي مثل التنبؤ بأسعار العملات و أسهم البورصة و أسعار العقارات و مبيعات منتج معين – )

كما يمكنك صنع بوتات محادثة Chat Boot لخدمة العملاء أو للاستشارات النفسية أو كدليل شامل للأعمال ..إلخ

ليكون مساعد رقمي ذكي يعمل بتقنيات الذكاء الاصطناعي للتعرف على أسئلة المستخدمين الصوتية و الكتابية و يعطي أفضل ردود نصية أو كتابية أو صورية من قواعد بيانات ضخمة بطريقة ذكية

كما يمكنك عمل برمجيات تحليل و عرض بيانات وصفية في هيئة رسوم بيانية و مؤشرات تحليلة دقيقة تساعد على اتخاذ قرارات هامة لأعمالك أو أعمال المؤسسة التي تعمل بها .

كما يمكنك كما أسلفنا صنع البرمجيات التي تعالج اللغة الطبيعية أو النصوص أو الصور ..

باختصار تقنيات و تكنولوجيا الذكاء الاصطناعي هي المستقبل

و من المهم أن تحصل أسس هذا العلم لأن فرص المستقبل معه وفيرة

عليكم جميعا أن تقوموا بتحصيل هذا الكورس الممتع

ثم سنقوم عبر مجموعتنا و صفحتنا رابطة محبي الذكاء الاصطناعي بعمل ورشة تطبيقية لعمل تطبيقات ذكاء اصطناعي عربية مفتوحة المصدرمثل روبوت عربي قادر على الإجابة عن اسئلة متنوعة اقتصادية و علمية و نفسية .. أو برنامج لتتعرف على الصور و تحويلها لنصوص ..لنقوم بتطبيق حلقات الكورس عمليا و نظن أنها الطريقة المثلى للتعامل مع الأكواد البرمجية هي تطبيقها عمليا لتثبيت و فهم المعلومات كما سنقوم بمناقشة أجزاء الكورس و حلقات الكورس و سنعمل على تجميع أسئلة هامة ملخصة نرسلها للدكتورة غيدا ابراهيم لتراجعنا بإجابات ملخصة تزيد من عمق فهمنا للكورس .

رابط الكورس

https://www.edraak.org/course/course-v1:Edraak+DS100+2019SP/